Mineria de datos aplicada a la encuesta permanente de hogares

Mineria de datos aplicada a la encuesta permanente de hogares alfonsocutro 28 Enero, 2010 - 13:51Con la denominada sociedad de la información se está produciendo un fenómeno curioso, día a día se multiplica la cantidad de datos almacenados. Sin embargo, contrariamente a lo que pudiera esperarse, esta explosión de datos no supone un aumento de nuestro conocimiento, puesto que resulta imposible procesarlos con los métodos clásicos.

La información que se genera diariamente dentro de la organización es uno de sus activos principales, por lo que se debe orientar los recursos tecnológicos de manera que ayuden a los ejecutivos a tomar decisiones estratégicas y oportunas.

La capacidad de solucionar problemas de decisión, y la calidad de las decisiones tomadas, tienen grandes repercusiones en la organización y en su correcto funcionamiento, de modo que actualmente las organizaciones se enfrentan a la paradoja de que, cuantos más datos están disponibles, menos información se tiene.

Para enfrentar estos problemas, en los últimos años han surgido una serie de técnicas que facilitan el procesamiento avanzado de los datos y permiten realizar un análisis en profundidad de los mismos de forma automática. La idea clave es que los datos contienen más información oculta de la que se ve a simple vista.

En este trabajo se propone desarrollar un proceso de extracción de conocimiento a partir de los datos de la Encuesta Permanente de Hogares (EPH) suministrados por el Instituto Nacional de Estadística y Censos (http: //www. indec. mecon. ar/).}

Introducción a la Minería de Datos

Introducción a la Minería de Datos alfonsocutro 24 Febrero, 2010 - 23:041.1 Los Datos y el Origen de la Información

1.1 Los Datos y el Origen de la Información alfonsocutro 24 Febrero, 2010 - 23:09El dato es un hecho que describe un suceso o una entidades.

La importancia de los datos está en su capacidad de asociarse dentro de un contexto para convertirse en información.

Por sí mismo los datos no tienen capacidad de comunicar un signi>cado y por lo tanto no pueden afectar el comportamiento.

En cambio la información reduce nuestra incertidumbre (sobre algún aspecto de la realidad) y, por tanto, nos permite tomar mejores decisiones.

1.2 El Procesamiento de los Datos

1.2 El Procesamiento de los Datos alfonsocutro 24 Febrero, 2010 - 23:16Los datos necesitan alojarse en un lugar físico (memoria) para su posterior procesamiento o ejecución. Hasta el momento se ha supuesto que los datos no son tan voluminosos y por lo tanto caben en memoria.

Sin embargo, existen problemas en donde el volumen de datos es tan grande que es imposible mantenerlos en memoria. Entonces, los datos se almacenan en un conjunto de archivos, los que forman una base de datos.

Día a día se multiplica la cantidad de datos almacenados, sin embargo, contrariamente a lo que pudiera esperar, esta explosión de datos no supone un aumento de nuestro conocimiento, puesto que resulta imposible procesarlos con los métodos clásicos.

Es así que hoy las organizaciones tienen gran cantidad de datos almacenados y organizados, pero a los cuales no los pueden analizar e>cientemente en su totalidad.

Con algunas sentencias de SQL se puede realizar un primer análisis, pero la mayoría de las veces, se requiere la utilización de técnicas más avanzadas.

El descubrimiento de conocimiento en bases de datos apunta a procesar automáticamente grandes cantidades de datos para encontrar conocimiento útil en ellos.

1.3 Descubrimiento de Conocimiento en Bases de Datos (KDD)

1.3 Descubrimiento de Conocimiento en Bases de Datos (KDD) alfonsocutro 24 Febrero, 2010 - 23:24El KDD ( Knowledge Discovery from Databases) es el proceso no trivial de identicar patrones válidos, novedosos, potencialmente útiles y en última instancia, comprensibles a partir de los datos. [10]

El objetivo fundamental del KDD ( Knowledge Discovery from Databases), es encontrar conocimiento útil, válido, relevante y nuevo sobre una determinada actividad mediante algoritmos, dadas las crecientes órdenes de magnitud en los datos (ver fig. 1.1).

Figura 1.1: Proceso del KDD( Knowledge Discovery from Databases).

Al mismo tiempo hay un profundo interés por presentar los resultados de manera visual o al menos de manera que su interpretación sea muy clara.

El resultado de la exploración deberá ser interesante y su calidad no debe ser afectada por ruido en los datos.

1.4 Estructuración de los Datos

1.4 Estructuración de los Datos alfonsocutro 24 Febrero, 2010 - 23:33Para poder analizar los datos con >abilidad es necesario que exista una cierta estructuración y coherencia entre los mismos [11].

Generalmente, la información que se quiere investigar sobre un cierto dominio de la organización se encuentra en bases de datos y otras fuentes muy diversas, y a su vez estas pueden ser tanto internas como externas.

Surge aquí la necesidad de conjugar los distintos >cheros y bases de datos de manera que se pueda utilizarlos para extraer conclusiones.

Solucionados los inconvenientes de heterogeneidad de las fuentes, surgen otros problemas relacionados a la estandarizacion de los datos:

- Diferentes tipos de datos representando el mismo concepto (ejemplo: la representación de fecha, donde al año se lo puede guardar con dos o cuatro dígitos).

- Diferentes claves para representar el mismo elemento (ejemplo: un mismo cliente puede ser representado por un código de cliente o por un NIF).

- Diferentes niveles de precisión al representar un dato (ejemplo: los números reales no siempre se almacenan de la misma forma, y es posible que generen algún problema.

Como se ve, la estructuracion de los datos no es sencilla y esto se agrava cuando los diferentes >cheros se encuentran en sistemas informáticos y soportes diferentes.

Por ello la calidad de los resultados está directamente relacionada con la correcta comprensión y posterior estructuración de los datos almacenados.

Lo razonable sería recoger los datos (información histórica) en un sistema separado y especí>co. Nace el Data-Warehousing: Almacenes o Bodegas de Datos, con la necesidad de uni>car los distintos >cheros y bases de datos para poder comprenderlos. Por ello, se necesita de tecnologías que sirvan de guía para comprender el contenido de las Bases de Datos.

1.5 Data Warehouse (DW), Bodegón de Datos o Almacén de Datos

1.5 Data Warehouse (DW), Bodegón de Datos o Almacén de Datos alfonsocutro 24 Febrero, 2010 - 23:36Básicamente se la puede describir como una combinación hardware, software especializado y datos provenientes de distintas fuentes que sirve a la administración para la toma de decisiones [12].

Es un sistemas de información orientado a la toma de decisiones empresariales que almacenando de manera integrada la información relevante del negocio, permite la realización de consultas complejas con tiempos de respuesta cortos.

El Data Warehouse es un almacén estructurado de la información clave de nuestro negocio, que integra datos provenientes de todos los departamentos, sistemas, etc., y que nos permite analizar el funcionamiento de nuestra compañía y tomar de decisiones sobre su gestión.

Es un almacén destinado especí>camente para mantener datos organizados.

1.5.1 Características del DW

1.5.1 Características del DW alfonsocutro 24 Febrero, 2010 - 23:39Un Data Warehouse es una colección de datos orientados a temas integrados, no volátiles y variantes en el tiempo, organizados para soportar necesidades empresariales [11]

Por ello es que un Data Warehouse se caracteriza por ser Integrado, Temático, Histórico y No volátil.

Integrado, es decir que al Huir del entorno operacional al entorno de almacén de datos, los datos asumen una codi>cación consistente.

Temático, debido a que almacena información resumida que se estructura en función de temas empresariales u organizacionales.

Histórico, dado que contiene su>ciente espacio para almacenar datos que posean una antigüedad de diez años o mayor aun .

No volátil, es decir los datos no se modi>can o cambian bajo ningún concepto una vez introducidos en el almacén de datos, únicamente puede ser cargados o leídos.

1.5.2 Bene1cios del DW

1.5.2 Bene1cios del DW alfonsocutro 24 Febrero, 2010 - 23:41Las claves que provee el Data Warehouse son, por un lado la creación de una arquitectura de datos única para todas las aplicaciones, como se vemos en la fig.g. 1.2 y también la resolución de problemas de integridad y calidad de datos.

Figura 1.2: Principales Aplicaciones del Data Warehouse.

Permitiendo así a los Administradores de Bases de Datos que redacten informes o analicen estas grandes cantidades de información, para así poder tomar decisiones según los resultados del análisis [13].

1.5.3 Construcción del DW

1.5.3 Construcción del DW alfonsocutro 25 Febrero, 2010 - 15:23Un Data Warehouse se genera a partir de otras bases de datos, su construcción y desarrollo requiere integrar varios componentes de tecnología y la habilidad para hacerlos funcionar todos juntos [4].

El objetivo fundamental es transformar datos en conocimiento.

Para ello es necesario ensamblar datos existentes siguiendo instrucciones precisas para obtener un óptimo resultado.

Para su construcción se debe considerar en primer lugar el hardware necesario, dado que a mayor tamaño del almacén, mayor deberá ser la capacidad de almacenamiento y el procesamiento. Luego el software y los datos que se utilizarán.

Las Principales etapas de construcción del Almacén de Datos son:

• Extracción: Se crea los archivos de la Base de Datos para transacciones y se guardan en el servidor que mantendrá el Almacén de Datos (se extrae la información operacional).

• Depuración: Se uni>ca la información de los datos de manera que se pueda insertar en el Almacén de Datos (se transforma la información a un formatos consistentes).

• Carga: Se trans>ere los archivos depurados a la base de datos que servirá como almacén de datos.

• Comparación: Se comparan los datos del almacén con los originales.

De todas maneras, el éxito de Data Warehouse no está en su construcción, sino en saber utilizarlo para mejorar procesos empresariales, operaciones y decisiones.

1.5.4 Información Oculta en los DW

1.5.4 Información Oculta en los DW alfonsocutro 25 Febrero, 2010 - 15:25Si se almacena la información mas relevante de nuestro negocio en un sistema que acumula y acumula datos sin parar, un análisis razonable nos puede permitir descubrir tendencias, localizar grupos de datos con comportamiento homogéneo, establecer relaciones, etc [2].

Esta información está oculta en los datos y será necesario utilizar todas las técnicas a nuestro alcance para obtenerla. El objetivo que nos planteamos es localizar relaciones entre atributos de nuestro Data Warehouse.

1.5.5 DW Como Soporte de Decisión Para Los Negocios

1.5.5 DW Como Soporte de Decisión Para Los Negocios alfonsocutro 25 Febrero, 2010 - 15:39Los negocios necesitan aprovechar las posibilidades que les ofrece la actual tecnología para permanecer competitivos y rentables.

El conocimiento del mercado y de los clientes se ha convertido en un factor de supervivencia para las empresas, y el Data Warehouse se per>la como la tecnología para lograr manejarlo.

Las organizaciones necesitan información renovada acerca de las tendencias presentes para mantener su competitividad. Precisan saber qué es lo que está pasando por las mentes de sus clientes.

Asimismo, necesitan determinar los requerimientos corporativas y traducirlos en consultas que puedan ser respondidas a través del Data Warehouse.

Para ello, el Data Warehouse conserva información histórica y actual sobre un negocio, y permite recuperar datos que, bajo la forma de informes, facilitan el descubrimiento y las comprensión de patrones de comportamiento y tendencias de las cuales resultan conclusiones o recomendaciones para los futuros cursos de acción.

Sintetiza algunos datos muy importantes, otorgando al usuario nuevo conocimiento comercial.

1.6 Inteligencia de Negocios

1.6 Inteligencia de Negocios alfonsocutro 25 Febrero, 2010 - 15:45Hace referencia a un conjunto de productos y servicios para acceder a los datos, analizarlos y convertirlos en información.

Es un paraguas bajo el que se incluye un conjunto de conceptos y metodologías cuya misión consiste en mejorar el proceso de toma de decisiones en los negocios basándose en hechos y sistemas que trabajan con hechos. [Howard Dresner ,Gartner Group, 1989].

La Inteligencia de Negocios es una manera de manejar la información histórica de una empresa a través de la construcción de un Data Warehouse, y explotarla con >nes de análisis para una mejor toma de decisiones [8].

A través de la creación de modelos de información multidimensionales una organización puede bene>ciarse al conocer de manera óptima cómo su negocio se ha comportado a lo largo del tiempo, cómo se comporta en el presente y cómo se estima se comportará en el futuro [7].

Algunos de los beneficios que obtienen las organizaciones al implementar este sistemas son:

- Capacidad de análisis.

- Reducción de costos.

- Reducción de tiempos de proceso.

- Búsqueda de patrones desconocidos que sólo aparecen al momento en que los datos son analizados.

- Generación de pronósticos, presupuestación y planeación.

La inteligencia en el negocio electrónico, incluye actividades como el procesamiento analítico en línea (OLAP) y aprovechamiento de datos, también llamada extracción de datos o Minería de Datos (verfig. 1.3).

1.7 Mineria de Datos

1.7 Mineria de Datos alfonsocutro 25 Febrero, 2010 - 15:53Figura 1.3: Inteligencia de Negocios BI.

La Minería de Datos es la etapa de descubrimiento en el proceso de KDD (Knowledge Discovery from Databases): “paso consistente en el uso de algoritmos concretos que generan una enumeración de patrones a partir de los datos preprocesados” [3].

Para conseguirlo hace uso de diferentes tecnologías que resuelven problemas típico de agrupamiento automático, clasi>cación y asociación de atributos, etc.

La Minería de Datos es, en principio, una fase dentro de un proceso global denominado Descubrimiento de Conocimiento en Bases de Datos, aunque >nalmente haya adquirido el signi>cado de todo el proceso en lugar de la fase de extracción de conocimiento [5].

Es un mecanismo de explotación, consistente en la búsqueda de información valiosa en grandes volúmenes de datos.Está muy ligada a las Bodegas de Datos ya que las mismas proporcionan la información histórica con la cual los algoritmos de minería tiene la información necesaria para la toma de decisiones [4].

El Data Mining (DM) es un conjunto de técnica de análisis de datos que permiten:

- Extraer Patrones, Tendencias y Regularidades para describir y comprender mejor los datos.

- Extraer Patrones y Tendencias para predecir comportamientos futuros.

Debido al gran volumen de datos este análisis:

- Ya no puede ser manual (ni incluso facilitado por herramientas de Almacén de Datos).

- Ha de ser (semi-) automático.

En los sistemas estándar de gestión de bases de datos las consultas se resuelven accediendo a distintos conjuntos de datos almacenados.

Los sistemas de Data Mining (DM) in>eren conocimiento de las bases de datos en forma de Estructuras y Patrones. Este conocimiento supone un nuevo conjunto de información en base a la cual se responden las consultas.

1.7.1 Evolución Historia de la Minería de Datos

1.7.1 Evolución Historia de la Minería de Datos alfonsocutro 26 Febrero, 2010 - 11:51La idea de Minería de Datos no es nueva. Ya desde los años sesenta los estadísticos manejaban términos como Data Fishing, Data Mining (DM) o Data Archaeology con la idea de encontrar correlaciones sin una hipótesis previa en bases de datos con ruido.

A principios de los años ochenta, Rakesh Agrawal, GioWiederhold, Robert Blum y Gregory Piatetsky-Shapiro entre otros, empezaron a consolidar los términos de Minería de Datos y KDD.

Esta tecnología ha sido un buen punto de encuentro entre personas pertenecientes al ámbito académico y al de los negocios.

La evolución de sus herramientas en el transcurso del tiempo puede dividirse en cuatro etapas principales:

- Colección de Datos (1960).

- Acceso de Datos (1980).

- Almacén de Datos y Apoyo a las Decisiones (principios de la década de 1990).

- Minería de Datos Inteligente.(nales de la década de 1990).

1.7.2 Aplicacion de la Minería de Datos

1.7.2 Aplicacion de la Minería de Datos alfonsocutro 26 Febrero, 2010 - 12:07En Internet

— E-bussines: Perfiles de clientes, publicidad dirigida, fraude.

— Buscadores Inteligentes: Generación de jerarquías, bases de conocimiento web.

— Gestión del Tráfico de la Red: Control de e>ciencia y errores.

El Mundo de los Negocios

— Banca: Grupos de clientes, préstamos, oferta de productos.

— Compañías de Seguros: Detección de fraude, administración de recursos.

— Marketing: Publicidad dirigida, estudios de competencia.

En Mundo de la Ciencias

— Meteorología:Teleconexiones (asociaciones espaciales), predicción.

— Física: Altas energías, datos de colisiones de partículas (búsqueda de patrones).

— Bio-Informática: Búsqueda de patrones en ADN, proyectos cientí>cos como genoma humano, datos geofísicos, altas energías, etc.

1.7.3 Ejemplos de las Aplicaciones de la Mineria de Datos

1.7.3 Ejemplos de las Aplicaciones de la Mineria de Datos alfonsocutro 26 Febrero, 2010 - 12:28En el Area de la Meteorología

Teleconexiones: Son predicción de asociaciones espaciales sobre una determinada Área Geográfica (ver fig. 1.5).

Existen bases de datos con simulaciones de los campos atmosféricos en rejillas dadas (ver fig. 1.4).

Se dispone de gran cantidad de información en observatorios locales: precipitaciónes, temperaturas, vientos, etc. (ver fig. 1.6).

En el Ambito de la Web

- Reglas de Asociación:

El 60% de las personas que esquían viajan frecuentemente a Europa.

- Clasificación:

Figura 1.4: Areas de los Campos Atmosféricos.

Figura 1.5: Analisis sobre una determinada Área Geográfica.

Figura 1.6: Información obtenida en los observatorios.

Personas menores de 40 años y salario superior a $2000 compran on-line frecuentemente.

- Clustering:

Los usuarios A y B tienen gustos parecidos (acceden URLs similares).

- Detección de “Outliers”:

El usuario A navega en Internet más del doble del tiempo promedio. [5]

1.8 Sistemas OLAP (On-Line Analytical Processing)

1.8 Sistemas OLAP (On-Line Analytical Processing) alfonsocutro 26 Febrero, 2010 - 12:45El procesamiento analítico en línea se de>ne como el análisis rápido de información compartida [1].

Aparece en contraposición al concepto tradicional OLTP (On-Line Transactional Processing), que designa el procesamiento operacional de los datos,orientado a conseguir la máxima eficacia y rapidez en las transacciones individuales de los datos.

Es una aplicación de bases de datos orientada a array que permite visualizar, manipular y analizar bases de datos multidimensionales.

Permite a los usuarios analizar datos corporativos críticos para descubrir los factores decisivos que inHuyen en el negocio. Realizan todas las tareas analíticas y de reporte incluyendo informes de medidas de rendimiento del negocios que resaltan indicadores de rendimiento clave.

1.8.1 Las Herramientas del OLAP

1.8.1 Las Herramientas del OLAP alfonsocutro 26 Febrero, 2010 - 12:52Están basadas generalmente en sistemas o interfaces Multidimensionales.

Utilizan operadores específicos (además de los clásicos):

- Drill.

- Roll.

- Pivot.

- Slice.

- Dice.

El resultado se presenta de una manera Matricial o Hibrida.

1.8.2 Principales Bene1cios del OLAP

1.8.2 Principales Bene1cios del OLAP alfonsocutro 26 Febrero, 2010 - 12:54Permite a los usuarios de entender no solo lo que está pasando, sino cuándo, por qué y cómo.

Resuelve todas las necesidades de análisis con una herramienta de velocidad electrónica.

Proporciona capacidades de análisis para todos los tipos de usuario así como para clientes y proveedores.

Bibliografía

Bibliografía alfonsocutro 26 Febrero, 2010 - 13:11[1] Jhon Wiley Alan Simon and Sons. Data Warehouse, Data Mining and OLAP. USA, 1997.

[2] Mc Graw Hill Alex Berson, Stephen J. Smith. Data Warehouse, Data Mining and OLAP. USA, 1997.

[3] G.; Smith P.; Ramasasmy U. Fayyad, U.M.; Piatetskiy-Shapiro. Advances in Knowledge Discovery and Data Mining. AAAI Press / MIT Press, 2006.

[4] IBM Software Group. Enterprise Data Warehousing whit DB2: The 10 Terabyte TPC-H Benchmark. IBM Press, USA, 2003.

[5] José M. Guitiérrez. Data Mining Extracción de Conocimiento en Grandes Bases de Datos. España, 2001.

[6] Manuel Palomar Juan C. Trujilla. Diseño de Almacenes de Datos. España, 2002.

[7] IBM Press. IBM DB2 Intelligent Miner for Data: Utilización del Visualizador de Asociaciones. IBM Press, USA, 1999.

[8] IBM Press. IBM DB2 Intelligent Miner for Data: Utilización de Intelligent Miner for Data. IBM Press, USA, 2002.

[9] Rudyanto Linngar Saida Davies, Surech Amujuri. WebSphere Business Integration Pub/Sub Solutions. IBM Press, USA, 2004.

[10] Platesky Shapiro C. Matheus W. Frawley, G. Knowledge Discovery in Database An Overview. Al Magazine, 1992.

[11] Jhon Wiley W. H. Inmon and Sons. Data Warehouse Performance. John Wiley, USA, 1992.

[12] Jhon Wiley W. H. Inmon and Sons. Building the Data Warehouse. John Wiley, USA, 1996.

[13] Colin J. White. IBM Enterprise Analytics for the Intelligent e-Business. IBM Press, USA, 2001.

Introducción a el DB2

Introducción a el DB2 alfonsocutro 26 Febrero, 2010 - 13:472.1 Introducción a las bases de datos

2.1 Introducción a las bases de datos alfonsocutro 26 Febrero, 2010 - 13:59Antes de las Bases de Datos se utilizaban archivos secuenciales para almacenar datos. Estos daban un acceso muy rápido pero sólo de forma secuencial en donde para acceder a una posición, se debía recorrer el archivo entero. Más tarde aparecieron los archivos indexados, donde el acceso ya podía ser aleatorio (acceder de una vez a la posición deseada del mismo).

El sistema de archivos era el sistema más común de almacenamiento de datos. Para compartirlos entre varias máquinas surgió el NFS2 (Network file system), y más tarde para evitar fallos en los sistemas de archivo aparecieron los sistemas RAID3 (Redundant Array Of Independent/Inexpensive Disks).

Pero los programas y datos cada vez eran más complejos y grandes. Se requería de un almacenamiento que garantizara un cierto número de condiciones y que permitiera operaciones complejas sin que se violaran estas restricciones.Además cada usuario que accediera a los datos debía tener su trabajo protegido de las operaciones que hicieran el resto de usuarios.

Respondiendo a estas necesidades, surgieron las Bases de Datos Jerárquicas, donde los datos se situaban siguiendo una jerarquía.

Las Bases de Datos Jerárquicas tenían el problema que los accesos a los datos eran unidireccionales, y era más complicado hacer el camino inverso (pero posible, aunque el tiempo de cálculo era mayor).

Por ejemplo: Era fácil saber qué cuentas tenía un cliente, pero no tanto saber de qué cliente era una cierta cuenta.

Para dar absoluta libertad a las relaciones entre tablas surgieron las Bases de Datos Relacionales (Relational Data Base Management System):

2.2 Definición de Bases de Datos

2.2 Definición de Bases de Datos alfonsocutro 10 Marzo, 2010 - 11:43Se define una Base de Datos como una serie de datos organizados y relacionados entre sí, y un conjunto de programas que permitan a los usuarios acceder y modificar esos datos. [?].

De forma sencilla podemos indicar que una Base de Datos no es más que un conjunto de información relacionada que se encuentra agrupada o estructurada.

Es un conjunto exhaustivo, no redundante de datos estructurados, organizados independientemente de su utilización y su implementación en máquina, accesibles en tiempo real y compatibles con usuarios concurrentes con necesidad de información diferente y no predecible en tiempo; donde la información se encuentra almacenada en una memoria auxiliar que permite el acceso directo a un conjunto de programas que manipulan esos datos [?].

Una Base de Datos es un conjunto de datos de operación almacenados y utilizados por los sistemas de aplicación de una empresa, y al mencionar empresa, se lo hace en sentido genérico y amplio, pero lo importante es que necesita de datos de operación referente a su funcionamiento.

Por ejemplo: Un Banco requiere datos de sus Clientes, una Mutual de sus Afiliados, un Hospital de sus Pacientes, una Facultad de sus Alumnos y Profesores.

La idea general es que estamos tratando con una colección de datos que cumplen las siguientes propiedades:

- Estánestructuradosindependientementedelasaplicacionesydelsoporte de almacenamiento que los contiene.

- Presentan la menor redundancia posible.

- Son compartidos por varios usuarios y/o aplicaciones.

2.3 Principales Diferencias con los Archivos Convencionales

2.3 Principales Diferencias con los Archivos Convencionales alfonsocutro 10 Marzo, 2010 - 11:48El Archivo por sí mismo no constituye una Base de Datos, sino más bien la forma en que está organizada la información es la que da origen a la Base de Datos.

Las Bases de Datos manuales, pueden ser difíciles de gestionar y modificar.

Por ejemplo: En una guía de teléfonos no es posible encontrar el número de un individuo si no sabemos su apellido, aunque conozcamos su domicilio.

Del mismo modo, en un Archivo de pacientes en el que la información esté desordenada por el nombre de los mismos, será una tarea bastante engorrosa encontrar todos los pacientes que viven en una zona determinada.

No podemos comparar directamente Base de Datos con Archivos, porque para ello es necesario tener más de un Archivo, pero si esto es así entraríamos en los problemas de: redundancia de datos, inconsistencia de datos, heterogeneidad de formatos de datos, no podemos compartir datos de las distintas aplicaciones, no manejamos la seguridad de todos los Archivos y por último ante pequeñas modificaciones en la estructura de los datos se requiere de muchas horas de programación para adecuar las mismas.

Los problemas expuestos anteriormente se pueden resolver creando un Sistemas de Gestión de Bases de Datos (SGBD), DBMS (Data Base Management System). .

2.4 Orígenes y Antecedentes de las Bases de Datos

2.4 Orígenes y Antecedentes de las Bases de Datos alfonsocutro 10 Marzo, 2010 - 12:03

El término Base de Datos fue acuñado por primera vez en 1963, en un simposio celebrado en California.

En la década del 70

Edgar Frank Codd definió el modelo relacional y publicó una serie de reglas para la evaluación de administradores de sistemas de datos relacionales y asi nacieron las bases de datos relacionales.

A partir de los aportes de Codd el multimillonario Larry Ellison desarrolló la base de datos Oracle, la cual es un sistema de administración de Base de Datos, que se destaca por sus transacciones, estabilidad, escalabilidad y multiplataforma.

Inicialmente no se usó el Modelo Relacional debido a que tenía inconvenientes por el rendimiento, ya que no podían ser competitivas con las bases de datos Jerárquicas y de Red. Ésta tendencia cambio por un proyecto de IBM el cual desarrolló técnicas para la construcción de un sistema de bases de datos relacionales eficientes, llamado System R.

En la década del 80

Las Bases de Datos Relacionales con su sistema de Tablas, Filas y Columnas, pudieron competir con las Bases de Datos Jerárquicas y de Red, ya que su nivel de programación era bajo y su uso muy sencillo.

En esta década el Modelo Relacional ha conseguido posicionarse en el mercado de las Bases de Datos. Y también en este tiempo se iniciaron grandes investigaciones, como las Sistemas de Gestión de Bases de Datos Orientadas a Objetos SGBDOO (System Management Object Oriented Databases). .

Principios década de los 90

Para la toma de decisiones se crea el lenguaje SQL (Structured Query Language) , que es un lenguaje programado para consultas. El programa de alto nivel SQL es un lenguaje de consulta estructurado que analiza grandes cantidades de información, el cual permite especificar diversos tipos de operaciones frente a la misma información, a diferencia de las bases de datos de los 80 que eran diseñadas para las aplicaciones de procesamiento de transacciones. Los grandes distribuidores de bases de datos incursionaron con la venta de bases de datos orientadas a objetos.

Finales de la década de los 90

El boom de esta década fue la aparición de la WWW “Word Wide Web” ya que por este medio se facilitaba la consulta de las bases de datos. Actualmente tienen una amplia capacidad de almacenamiento de información, también una de las ventajas es el servicio de siete días a la semana las veinticuatro horas del día, sin interrupciones a menos que haya planificaciones de mantenimiento de las plataformas o el software.

2.5 Modelo de Base de Datos

2.5 Modelo de Base de Datos alfonsocutro 10 Marzo, 2010 - 12:07Además de la clasificación por la función de las Bases de Datos, éstas también se pueden clasificar de acuerdo a su Modelo de Administración de Datos.

Un Modelo de Datos es básicamente una “descripción” de algo conocido como contenedor de datos (algo en donde se guarda la información), así como de los métodos para almacenar y recuperar información de esos contenedores. Los Modelos de Datos no son cosas físicas; son abstracciones que permiten la implementación de un sistema eficiente de Bases de Datos, por lo general se refieren a algoritmos, y conceptos matemáticos.

2.6 Organización de Sistema de Gestión de Bases de Datos (SGBD)

2.6 Organización de Sistema de Gestión de Bases de Datos (SGBD) alfonsocutro 10 Marzo, 2010 - 12:09Los Modelos más comunes de organización de Bases de Datos son:

- Jerárquico.

- En Red.

- Relacional.

- Orientado a Objetos.

2.6.1 Bases de Datos Jerárquicas

2.6.1 Bases de Datos Jerárquicas alfonsocutro 10 Marzo, 2010 - 12:28Una base de datos jerarquica estructura los campos en nodos en una estructura jerárquica. Los nodos son puntos conectados entre sí formando una especie de árbol invertido. Cada entrada tiene un nodo padre, que puede tener varios nodos hijos; esto suele denominarse relación uno a muchos. Los nodos inferiores se subordinan a los que se hallan a su nivel inmediato superior.

Un nodo que no tiene padre es llamado raíz, en tanto que los que no tienen hijos son conocidos como hojas. Cuando se desea hallar un campo en particular, se empieza por el tope, con un nodo padre, descendiendo por el árbol en dirección a un nodo hijo.

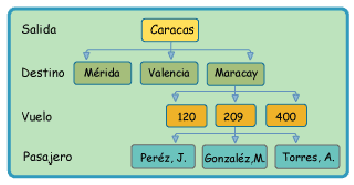

Por Ejemplo: Un Sistema de Reservaciones de una Línea Aérea (ver fig.2.1).

El Nodo Padre en esta base de datos jerárquica es la Ciudad de Salida en este caso es (Caracas), Nodos Hijos representando las Ciudades Destino que tiene a su vez Nodos Hijos, que son el Número de Vuelo. El Número de Vuelo tendrá también Nodos Hijos, que son los Pasajeros.

Figura 2.1: Modelo de Bases de Datos Jerárquica

Limitaciones de las Bases de Datos Jerárquicas

- Al borrar un nodo padre, desaparecen también sus nodos subordinados.

- Sólo podrá añadirse un nodo hijo, si existe el nodo padre.

- Pero lo más significativo es la rigidez de su estructura: sólo un padre por hijo y ausencia de relaciones entre los nodos hijos.

2.6.2 Bases de Datos en Red

2.6.2 Bases de Datos en Red alfonsocutro 10 Marzo, 2010 - 12:37Como en el caso de las bases de datos jerárquicas, se trata de una organización jerárquica de nodos, pero un nodo hijo puede tener más de un solo nodo padre (relación muchos a muchos). En las bases de datos en red, existen los punteros, que son conexiones adicionales entre nodos padres y nodos hijos, que permiten acceder a un nodo por vías distintas accediendo al mismo en dirección descendente por las diversas ramas.

La base de datos en red representa una mejora al modelo jerárquico.

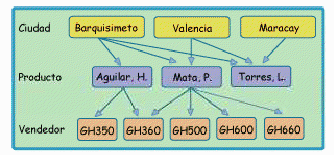

Por ejemplo: Los vendedores destacados para distribuir determinados productos en algunas ciudades pueden ilustrar este modelo (ver fig. 2.2).

Cada Producto puede ser distribuido por más de un Vendedor, así mismo cada Vendedor puede encargarse de diferentes Ciudades.

Figura 2.2: Modelo de Bases de Datos en Red

2.6.3 Bases de Datos Relacional

2.6.3 Bases de Datos Relacional alfonsocutro 10 Marzo, 2010 - 12:45Esta organización ofrece la mayor flexibilidad ya que los datos se almacenan en Tablas diferentes, conformadas así mismo por Filas y Columnas. Una tabla se denomina relación. En una Tabla las Filas contienen los Registros. Las Columnas representan los Campos. Las Tablas relacionadas poseen un campo común, el Campo Clave, mediante el cual la información almacenada en una tabla puede enlazarse con la información almacenada en otra.

El acceso a los datos se realiza mediante consultas escritas en SQL (Structured Query Language). La Organización de Bases de Datos Relacional es la más difundida en la actualidad debido a su sencillez para realizar operaciones de adición, eliminación y modificación en contraste con la mayor rigidez de las Organizaciones Jerárquicas y de Red.

Por ejemplo: En un pequeño negocio, se puede contar con una Tabla de Clientes y Tabla de Pedidos (ver fig. 2.3).

Las órdenes que pertenecen a un determinado cliente son identificadas colocando el campo de identificación del cliente en la orden (campo clave de la tabla de clientes), lo cual permite enlazar las dos tablas.

Figura 2.3: Modelo de Bases de Datos Relacional

Limitaciones de las Base de Datos Relacionales

- Estructuras muy simples (1FN).

- Poca riqueza semántica.

- No soporta tipos definidos por el ususarios (solo Dominios).

- No soporta Recursividad.

- Falta de Procesamiento/Disparadores.

- No admite Herencia.

2.6.4 Bases de Datos Orientadas a Objetos (BDOO)

2.6.4 Bases de Datos Orientadas a Objetos (BDOO) alfonsocutro 10 Marzo, 2010 - 13:09Que es la O.O. (Object-Oriented)

El Análisis Orientado a Objetos (O.O.) no es un enfoque que modela la realidad. En lugar de esto, modela la forma en que las personas comprenden la realidad.

Un Objeto es una representación detallada, concreta y particular de un “algo”. Tal representación determina su Identidad, su Estado y su Comportamiento particular en un momento dado

- Identidad: Le permite a un Objeto ser distinguido de entre otros y esto se da gracias al nombre que cada Objeto posee.

- Estado: El estado de un Objeto es el conjunto de valores concretos que lo caracterizan en un momento dado, como peso, color, precio, etc.

- Comportamiento: Define un conjunto de funciones que el objeto es capaz de llevar a cabo. Tales funciones pueden estar relacionadas entre sí, modificar el estado del objeto o invocar funcionalidades de otros objetos, entre muchas otras cosas más.

Una Clase se define como la generalización de un objeto en particular. Es decir, una Clase representa a una familia de Objetos concretos.

De lo anterior, podemos decir que una instancia de una clase es siempre un objeto en particular.

Qué es una Bases de Datos Orientadas a Objetos (B.D.O.O)

Es una estructura relativamente nueva que ha suscitado gran interés.

El Modelo de Datos Orientado a Objetos, es una adaptación para los sistemas de Bases de Datos del Paradigma de la Programación Orientada a Objetos. Se basa en el concepto de Encapsular elementos de datos, sus características, atributos y el código que opera sobre ellos en elementos complejos llamados Objetos.

Los Objetos estructurados se agrupan en Clases.

Por ejemplo: El conjunto de las clases se estructura en subclases y superclases como se puede ver en la fig. 2.4) [?].

Ventajas en BDOOs

- Se destaca su flexibilidad y soporte para el manejo de tipos de datos complejos.

Figura 2.4: Modelo de Bases de Datos Orientada a Objetos

- Manipula datos complejos en forma rápida y ágilmente. La estructura de la Base de Datos está dada por referencias (o apuntadores lógicos) entre Objetos [?].

Posibles Desventajas de la BDOOs

- La inmadurez del mercado de BDOO constituye una posible fuente de problemas por lo que debe analizarse con detalle la presencia en el mercado del proveedor para adoptar una línea de producción sustantiva.

- Es la falta de estándar en la industria Orientado a Objetos [?].

2.7 Introducción a DB2 UDB

2.7 Introducción a DB2 UDB alfonsocutro 10 Marzo, 2010 - 13:13DB2 UDB Universal Database es una Base de Datos Universal. Es completamente escalable, veloz y confiable.

Corre en modo nativo en casi todas las plataformas como ser: Windows NT, Sun Solaris, HP-UX, AIX U, OS/2 entre otros.

DB2 es un software de base de datos relacional. Es completamente multimedia, disponible para su uso en la Web, muy bueno para satisfacer las demandas de las grandes corporaciones y bastante flexible para servir a los

medianos y pequeños negocios. DB2 UDB es un sistema manejador de base de datos relacional fuertementeescalable. Es suficientemente flexible para atender estructuras e inestructuras manejadoras de datos necesarias para usuarios simples de grandes empresas. Es conveniente para una gama amplia de aplicaciones de los cliente, quienes pueden desplegar una variedad de plataformas de hardware y software desde dispositivos manuales a los sistemas multiprocesador paralelos masivos.

2.7.1 Características Generales del DB2 UDB

2.7.1 Características Generales del DB2 UDB alfonsocutro 10 Marzo, 2010 - 13:34DB2 UDB es el producto principal de la estrategia de Data Management deIBM.

DB2 UDB es un sistema para administración de Bases de Datos Relacionales (RDBMS). Es multiplataforma, especialmente diseñada para ambientes distribuidos, permitiendo que los usuarios locales compartan información con los recursos centrales. Es el sistema de gestión de datos que entrega una plataforma de base de datos flexible y rentable para construir un sistema robusto para aplicaciones de gestión.

DB2 UDB libera los recursos con amplio apoyo al open source (fuente abierta) y plataformas de desarrollo populares como J2EE y Microsoft .NET.

Integridad

El DB2 UDB incluye características de Integridad, asegurando la protección de los datos aún en caso de que los sistemas sufran un colapso, y de Seguridad permitiendo realizar respaldos en línea con distintos grados de granularidad, sin que esto afecte la disponibilidad de acceso a los datos por parte de los usuarios.

Múltiples usos

Provee la capacidad de hacer frente a múltiples necesidades, desde Procesamiento Transaccional de Misión Crítica (OLTP), hasta análisis exhaustivo de los datos para el soporte a la toma de decisiones (OLAP).

Escalabilidad

Sus características distintivas de Escalabilidad le permiten almacenar información en un amplio rango de equipos, desde un PC portátil hasta un complejo ambiente de mainframes procesando en paralelo.

Web enabled para e-business

Incluye tecnología basada en Web que permite generar aplicaciones en las Intranets y responder a las oportunidades de negocios disponibles en Internet.

Facilidad de Instalación y Uso

La primera versión de DB2 para NT fue reconocida en el mercado como una base de datos muy poderosa, pero difícil de instalar y usar.

En esta versión (DB2 UDB), IBM agregó muchas herramientas gráficas para facilitar el uso para los usuarios, como también para los administradores y desarrolladores. Dicha versión incluye guías para operaciones como instalación, configuración de performance, setup, etc. Además, se agregaron herramientas para facilitar las tareas de integración con otras bases de datos, tecnologías de networking y desarrollo de aplicaciones.

Universalidad

DB2 UDB es, además, la única base de datos realmente universal; es multiplataforma (16 plataformas - de las cuales 10 no son de IBM), brinda soporte a un amplio rango de clientes, soporta el acceso de los datos desde Internet y permite almacenar todo tipo de datos:

- Texto, Audio, Imágenes y Video (AIV Extender) (ver fig. 2.5) .

- Documentos XML ( XML Extender) (ver fig. 2.6).

Figura 2.5: AIV Extender

Figura 2.6: XML Extender

Figura 2.7: Almacenamiento de Imagenes en DB2

Ejemplos de los Formatos de datos soportados por el DB2 UDB:

- Video: playback, streaming, etc.

- Imgenes: almacenamiento y búsqueda por patrones de colores y texturas (ver fig. 2.7).

- Audio: maneja diferentes formatos de audio.

Permitiendo realizar :

- Búsquedas Textuales: Net Search Extender, Text Extender.

- Información Espacial: Spatial Extender, Geodetic Extender.

El Spatial Extender DB2 y el Geodetic Extender DB2 utilizan diversas tecnologías de la base de datos. El Spatial Extender utiliza un mapa plano (o planar), basado en coordenadas proyectadas. Sin embargo, ninguna proyección del mapa puede representar fielmente la tierra entera porque cada mapa tiene bordes; mientras que, la tierra no tiene bordes.

El Geodetic Extender utiliza un elipsoide como su modelo para tratar la tierra como un globo íntegrol que no tiene ninguna distorsión en los postes o bordes en el 180o del meridiano.

2.7.2 Funciones Complementarias del DB2 UDB

2.7.2 Funciones Complementarias del DB2 UDB alfonsocutro 11 Marzo, 2010 - 14:49Conectividad

Las herramientas de conectividad permiten acceder a los datos más allá de donde ellos se encuentren. El slogan cualquier cliente, a cualquier servidor, en cualquier red está completamente sustentado por la funcionalidad que sus herramientas ofrecen. DB2 permite acceder a los datos de DB2 en mainframe o AS/400, desde Windows NT, Windows 95/98, OS/2 o cualquiera de los Unix soportados. Además, el producto Datajoiner posibilita acceder de forma única y transparente a los datos residentes en Oracle, Sybase, Informix, Microsoft SQL Server, IMS, VSAM y otros.

Data Warehousing

El DB2 UDB provee la infraestructura necesaria para soportar el proceso de toma de decisiones en cualquier tamaño y tipo de organización. Está dirigido a resolver la problemática a nivel departamental (Data Marts), ya que un único producto provee la capacidad para acceder a datos en Oracle, Sybase, Informix, Microsoft SQL Server, VSAM o IMS, además de la familia DB2.

Permite de forma totalmente gráfica acceder, transformar y distribuir los datos automáticamente y sin programar una línea de codigo (ver fig. 2.8).

Figura 2.8: DB2 Data Warehouse Edition Design Studio

Data Mining

Las empresas suelen generar grandes cantidades de información sobre sus procesos productivos, desempeño operacional, mercados y clientes. Pero el éxito de los negocios depende por lo general de la habilidad para ver nuevas tendencias o cambios en las tendencias.

Las aplicaciones de Data Mining pueden identificar tendencias y comportamientos, no sólo para extraer información, sino también para descubrir las relaciones en bases de datos que pueden identificar comportamientos que no son muy evidentes (ver fig. 2.9).

DB2 UDB posibilita el análisis orientado al descubrimiento de información escondida en los datos, realizando modelización predictiva, segmentación de la base de datos, análisis de vínculos, o detección de desviaciones.

Figura 2.9: Data Mining

Incluye las siguientes técnicas:

- Clustering (segmentación ).

- Clasificación.

- Predicción.

- Descubrimiento Asociativo.

- Descubrimiento Secuencial de Patrones.

- Descubrimiento Secuencias Temporales.

Todas las técnicas mencionadas permiten realizar:

- Segmentación de Clientes.

- Detección de Fraudes.

- Retención de Clientes.

- Ventas Cruzadas.

- etc.

2.8 Business Intelligence Para DB2 UDB

2.8 Business Intelligence Para DB2 UDB alfonsocutro 11 Marzo, 2010 - 14:55Las ediciones del DB2 Data Warehouse proporcionan gran funcionalidad de BI (Business Intelligence) dentro de las bases de datos.

Estas nuevas ediciones combinan la fuerza del DB2 UDB a la infraestructura esencial de Business Intelligence.

La tecnología basada en las ediciones del DB2 UDB Data Warehouse, permite integrar la información en:

- Tiempo Real.

- Percepción.

- Toma de Decisiones.

El DB2 Data Warehouse hacen más fácil, la implementacíon de la plataforma completa de BI (Business Intelligence) del DB2 , realizada por los clientes. Proporcionan gran funcionalidad de BI dentro de la base de datos.

La Edición Corporativa de DB2 Data Warehouse representa el marco más reciente de la evolución de DB2.

2.8.1 Funcionalidad de Business Intelligence

2.8.1 Funcionalidad de Business Intelligence alfonsocutro 11 Marzo, 2010 - 15:06 La funcionalidades del Business Intelligence incluyen:

• Servicios robustos de ETML (Extract, Transform, Load and Move) con agentes distribuidos para maximizar el desempeño.

• Aplicaciones eficaces de búsqueda de datos para modelado y visualización de rutinas y resultados de búsqueda, así como para la integración de aplicaciones analíticas.

• Optimizaciones integradas a OLAP para acelerar el desarrollo e implementación de aplicaciones analíticos.

• Soporte para configuraciones de servidores en cluster, MPP (Massively Parallel Processing) en una arquitectura true shared-nothing.

• Funcionalidad de administración de consultas y recursos para controlar, administrar y monitorear el ambiente de carga, de consultas y de actividades.

• Y además, todos los recursos de desempeño y funcionalidad de Business Intelligence en el DB2 UDB Enterprise Server Edition y más...(ver fig.2.10)

Figura 2.10: Herramientas del BI (Business Intelligence)

2.9 DB2 Data Warehouse

2.9 DB2 Data Warehouse alfonsocutro 12 Marzo, 2010 - 12:11Son sistemas que contienen datos de operaciones que se ejecutan en las transacciones diarias de una empresa. Estos contienen información que es útil para los analistas comerciales. Por ejemplo: Los analistas pueden utilizar información sobre qué productos se han vendido, en qué regiones y en qué época del año para buscar anomalías o para proyectar ventas futuras (ver fig. 2.11).

2.9.1 Esquema conceptual de un DB2 Data Warehouse

2.9.1 Esquema conceptual de un DB2 Data Warehouse alfonsocutro 12 Marzo, 2010 - 12:19El Data Warehouse se define en el Centro de Depósito de Datos del DB2 UDB para automatizar los procesos necesarios para poblar y mantener el depósito de datos.

Antes de definir el depósito se reúne información acerca de los datos operativos que se van a utilizar como entrada para el depósito y de los requisitos para los datos de depósito.

El Administrador de la Base de Datos es el responsable de los datos operativos, es una buena fuente de información acerca de los datos operativos.

Los usuarios de negocios que tomarán decisiones comerciales basadas en los datos del depósito son una buena fuente de información acerca de los requisitos del depósito.

Y finalmente se crea una Base de Datos que contendrá las tablas de destino del depósito, que consisten en datos de fuente de depósito limpios y transformados (ver fig. 2.12).

EL DB2 UDB incluye funciones y funcionalidades que transforman al DW en una plataforma que permite distribuir y manejar información multidimensional a través de la empresa. Estas convierten el Warehouse Relacional en una plataforma para el análisis OLAP de alta performance que permite el despliegue de los datos contenidos en cubos multidimensionales a lo largo de la empresa.(ver fig. 2.13).

2.9.2 Principales Problemas del DB2 Data Warehouse

2.9.2 Principales Problemas del DB2 Data Warehouse alfonsocutro 12 Marzo, 2010 - 12:24Se producen diversos problemas si los analistas acceden a los datos de operaciones directamente:

- Puede que no tengan conocimientos suficientes para consultar la base de datos de operaciones. Por ejemplo: La consulta de bases de datos IMS requiere un programa de aplicación que utiliza un tipo especializado de lenguaje de manipulación de datos. En general, los programadores que tienen los conocimientos para consultar la base de datos de operaciones tienen un trabajo a tiempo completo efectuando el mantenimiento de la base de datos y sus aplicaciones.

- El rendimiento es esencial para muchas bases de datos de operaciones, como por ejemplo las bases de datos de un banco. El sistema no puede manejar la realización de las consultas pertinentes por parte de los usuarios.

- Los datos de operaciones no acostumbran a estar en el formato óptimo para que los utilicen los analistas comerciales. Por ejemplo, los datos de ventas que se resumen por producto, región y temporada son mucho más útiles para los analistas que los datos sin clasificar

Introduccion al WebSphere Studio

Introduccion al WebSphere Studio alfonsocutro 12 Marzo, 2010 - 12:273.1 Introducción y Conceptos

3.1 Introducción y Conceptos alfonsocutro 12 Marzo, 2010 - 12:35WebSphere Studio Application Developer es un productos se ha desarrollado basado en el Workbench (banco de trabajo) de Eclipse .

La plataforma del Workbench de Eclipse fue diseñada por IBM y lanzado a la comunidad de open-source (código abierto).

Este Workbench se ha diseñado para proveer la máxima flexibilidad en el desarrollo de las herramientas y las nuevas tecnologías que pueden emerger en el futuro.

Los ambientes de desarrollo realizados para el Workbench deben apoyar a el modelo de desarrollo role-based (basado en roles).

La familia del WebSphere Studio Application Developer se basa en un ambiente integrado de desarrollo (IDE), donde este permite: Desarrollar, Probar, Eliminar errores y desplegar su usos. Donde también proporciona la ayuda para cada fase del desarrollo del ciclo vida.

Los líderes de la industria de software como: IBM, Borland, Merant, QNX Software Systems, Rational Software, RedHat, SuSE, TogetherSoft y WebGain formaron inicialmente la eclipse.org que actualmente administra los directores del Eclipse open source project.

Eclipse es una plataforma abierta para la integración de herramienta construida por una comunidad abierta de los abastecedores de la herramienta.

Está plataforma proporciona herramienta con la última flexibilidad y control sobre su tecnología del software.

Eclipse se ha diseñado desde la necesidad de Construir, Integrar los desarrollos útiles del uso de las tecnologías.

El valor más importante que tiene esta plataforma es: el rápido desarrollo de herramienta siendo esta una de las características basadas en un modelo plug-in (con enchufe) (ver fig. 3.1).

3.2 Productos WebSphere Studio

3.2 Productos WebSphere Studio alfonsocutro 12 Marzo, 2010 - 13:00WebSphere Studio (ver fig. 3.2) es actualmente conocida como una familia de productos de software propietario de IBM, aunque el término se refiere de manera popular a uno de sus productos específicos: WebSphere Application Server (WAS) .

Todos los productos del WebSphere Studio fuerón construidos sobre el Workbench de Eclipse como un sistema de plug-ins conforme al estándar APIs del Workbenchs.

La familia del WebSphere Studio tiene actualmente los siguientes miembros (ver fig. 3.3):

- WebSphere Studio Site Developer Advanced .

- WebSphere Studio Application Developer .

- WebSphere Studio Application Developer Integration Edition .

- WebSphere Studio Enterprise Developer .

Estos productos proporcionan la ayuda para el desarrollo, la prueba, y el despliegue end-to-end del Web y de los usos de J2EE (Java 2 Enterprise Edition) .

.png)

Cada producto de la familia WebSphere Studio presenta el mismo entorno de desarrollo integrado (IDE) y una base común de herramientas, por ejemplo para el desarrollo Java y Web (ver fig. 3.4).

WebSphere Studio es único entorno de desarrollo completo, diseñado para satisfacer todas las necesidades de desarrollo, desde interfaces Web a aplicaciones del lado del servidor en desarrollo individual a desarrollos avanzados en equipo, desde el desarrollo Java a la integración de aplicaciones. Además proporciona un conjunto de herramientas para facilitar el desarrollo de aplicaciones. Posee un entorno visual para la distribución de los elementos de una página Web usando Java Server Pages ( JSPs), HTML y Java Script, ayudando a un rápido desarrollo aplicaciones de e-business (comercio electrónico) con contenido dinámico.

Es ideal para el desarrollo de aplicaciones multiplataforma, comenzando desde pequeños sitios Web hasta megasitios. Proporciona código preconstruido y pretesteado. Permitiendo administrar cargas pico en los servidores Web.

3.2.1 WebSphere Studio Site Developer

3.2.1 WebSphere Studio Site Developer alfonsocutro 12 Marzo, 2010 - 13:06Site Developer es un IDE provisto para los desarrolladores Web y a los que administran y manejan site complejos.

Es un ambiente fácil de utilizar que reduce al mínimo el tiempo y el esfuerzo requerido para crear, maneja, y elimina errores del sitio Web multi-plataforma. Se diseña deacuerdo las especificaciones de J2SE , J2EE y soporta JSPs, servlets, HTML, Javascript, y DHTML. Además incluye herramientas para desarrollar imágenes y GIFs animado.

Site Developer le permite a los desarrolladores Web utilizar sus herramientas para la creación local incorporado la posibilidad de publican los proyectos remotamente.

Empleando Site Developer se podrá desarrollar las aplicaciones Web que utilizan las siguientes tecnologías:

- JSPs: Es una manera simple, rápida, y firme de ampliar la funcionalidad del servidor web y de crear el contenido dinámico de la Web.

- Servlets: Es el código del servidor que se ejecuta dentro de la aplicacion del servidor Web.

- Servicios de la Web: Son aplicaciones independientes, modulares que pueden ser representadas o publicadas sobre el Internet o dentro de Intranets.

3.2.2 WebSphere Studio Application Developer

3.2.2 WebSphere Studio Application Developer alfonsocutro 12 Marzo, 2010 - 13:10Application Developer fué diseñado para los desarrolladores profesionales de Java y de los utilizan el J2EE, y quiénes requieren integrar Java , Web y XML, con la ayuda de servicios de la Web.

Incluye todas las características del Site Developer, y además se agregan las herramientas para el desarrollo de aplicaciones EJB, así como funcionamiento instrumentos copiadores que registran tanto para ejecución local como para remota.

Los desarrolladores pueden construir y probar rápidamente la lógica de negocio y realizar las presentaciónes con instrumentos creados dentro de la Web por herramientas del Application Developer IDE antes que despliegue en un servidor.

Utilizando el desempeño de las herramientas copiadoras y trazadoras, es posible descubrir los embotellamientos del funcionamiento de las aplicación de forma temprana en el ciclo de desarrollo.

Además, el ambiente de prueba incorporado por el WebSphere Application Server posee instrumentos avanzados para la ayuda de la generación de código que acortan el ciclo de prueba.

3.2.3 WebSphere Studio Application Developer Integration Edition

3.2.3 WebSphere Studio Application Developer Integration Edition alfonsocutro 12 Marzo, 2010 - 13:13Integration Edition incluye toda la funcionalidad en el Application Developer, más:

- Poderosas herramientas gráficas para ayudar rápidamente y fácilmente la construccion adaptadores para integrar J2EE con el back-end del sistemas, ayudando a ahorrar tanto en tiempo como en dinero por reutilizando recursos existentes.

- Las herramientas visuales flow-based aumentan la productividad, permitiéndonos visualmente definir la secuencia y el flujo de información entre artefactos de aplicación como adaptadores, Enterprise JavaBeans componentes y servicios Web.

3.2.4 WebSphere Enterprise Developer

3.2.4 WebSphere Enterprise Developer alfonsocutro 12 Marzo, 2010 - 13:17Enterprise Developer incluye toda la funcionalidad WebSphere Studio Application Developer Integration Edition entre otros más:

- Ambientes transaccionales integrados tales como CICS e IMS.

- Desarrollar y mantener las aplicaciones z/OS.

- Soportá Java, COBOL, PL/I, y EGL (enterprise generation language).

- Puede implementar estructuras basadas en aplicaciones MVS utilizando conectores y EGL.

Otra tecnología que se que se integra en el Enterprise Developer :

- WebSphere Studio Asset Analyzer (WSAA): Identifica procesos en uso para conectar puntos, y proporcionar asi la capacidad de generar componentes del código existente

3.3 Entorno de Desarrollo de WebSphere Studio Application Developer

3.3 Entorno de Desarrollo de WebSphere Studio Application Developer alfonsocutro 12 Marzo, 2010 - 13:23WebSphere Studio Workbench, es una herramienta de integración abierta y extensible sobre la que es posible construir diferentes herramientas de terceros (plug-ins) (ver fig. 3.5). El Workbench está basado en la plataforma open-source Eclipse , y constituye la base de la siguiente generación de herramientas de desarrollo IBM.

WebSphere Studio Enterprise Developer es el entorno que acabará sustituyendo a VisualAge Generator.

Tanto si partimos de entornos de desarrollo IBM (VisualAge for Java) o de entornos de otros fabricantes (WebGain VisualCafé, BEA WebLogic).

3.4 Ventajas de migrar a WebSphere Studio Application Developer

3.4 Ventajas de migrar a WebSphere Studio Application Developer alfonsocutro 12 Marzo, 2010 - 13:26La ventaja fundamental consiste en la integración de todos los entornos de desarrollo Java, Web en una única plataforma de desarrollo.

3.4.1 J2EE:

3.4.1 J2EE: alfonsocutro 12 Marzo, 2010 - 13:30- Herramientas de importación/exportación, generación de código, edición de deployment descriptors estandars, extensiones y bindings (mapeos) específicos para WebSphere Application Server (WAS).

- Herramienta de mapeo EJB-RDB soportanto tanto top-down, como bottom-up y meet-in-the-middle.

- Herramientas de edición gráfica de esquemas de bases de datos.

- Herramientas para la creación, edición y validación de ficheros EAR.

- Editores para deployment descriptors (ejb-jar.xml y application.xml).

3.4.2 Desarrollo Java:

3.4.2 Desarrollo Java: alfonsocutro 12 Marzo, 2010 - 13:33- Nuevo Editor Visual Java para GUIs (Swing y AWT).

- Nueva generación de JavaDoc.

- Soporte JDK 1.3.

- Capacidad de utilizar diferentes JREs.

- Compilación incremental automática.

- Posibilidad de ejecutar código incluso con errores.

- Protección contra crashs y auto-recovery.

- Error Reporting y corrección.

- Editor Java con asistente contextual.

- Herramientas de refactoring de código.

- Búsquedas inteligentes y herramientas para comparar código y ”merge”.

- Scrapbook para evaluación rápida de código.

3.4.3 Web Services:

3.4.3 Web Services: alfonsocutro 12 Marzo, 2010 - 13:37- Nuevo soporte UDDI Version 2.

- Soporte UDDI privado.

- Nuevo soporte de WSIL.

- Posibilidad de crear un web service a partir de un fichero ISD.

- Visualización de UDDI business entry para localización de web services existentes.

- Creación de web services a partir de código existente (JavaBeans, RLSs, DB2 XML Extender calls, procedimientos almacenados DB2 y queries SQL).

- Crear wrappers SOAP y HTTP GET/POST de código existente.

- Generación de proxies desde el Web Services Client/Wizard para tratar mensajes SOAP.

- Generación de una aplicación de ejemplo, a partir de la cual crear el resto.

- Realizar el test de un web service local o remoto.

- Deployment de un web service sobre el entorno de test de tanto WebSphere Application Server como Tomcat.

- Publicar web services en un UDDI business registry.

- Nuevos menús pop-up para la creación y consumo de web services, además de los típicos wizards.

3.4.4 XML:

3.4.4 XML: alfonsocutro 12 Marzo, 2010 - 13:40- Entorno totalmente visual.

- Editor de XML con posibilidades de validación de documentos.

- Editor de DTD con posibilidades de validación de documentos.

- Editor de XML schemas.

- Editor de XSL.

- Debugger de XSL y herramienta de transformación para aplicar XSL a XML.

- Editor de mapping XML - XML.

- Wizard de creación de XML a partir de queries SQL.

- Editor de mapping RDB - XML.

3.4.5 Desarrollo web:

3.4.5 Desarrollo web: alfonsocutro 12 Marzo, 2010 - 13:44- Nuevo soporte para XHTML y Struts.

- Nuevo entorno visual de construcción de aplicaciones basado en struts.

- Editor visual de HTML y JSPs.

- Edición y validación de JavaScript.

- Soporte de JSP Custom tags (taglibs) 1.2.

- Edición de imágenes y animaciones.

- Edición de CSS.

- Importación via HTTP/FTP.

- Exportación vía FTP a un servidor.

- Visualización de links, broken links, etc.

- Wizards para la creación de servlets.

- Wizards para la creación de proyectos J2EE.

- Wizards para la creación de aplicaciones web.

3.4.6 Testing y Deployment:

3.4.6 Testing y Deployment: alfonsocutro 12 Marzo, 2010 - 13:48- Incrementa la productividad de forma muy importante.

- Entorno ligero de carga rápida.

- Permite pruebas unitarias locales.

- Permite debugger de código en el servidor a través del debugger integrado.

- Permite configurar deiferentes aplicaciones web.

- TCP/IP monitoring server.

- Permite instalar los siguientes entornos, tanto locales como remotos:

(WebSphere Application Server AEs Version 4.0.3 and Version 5, WebSphere Application Server - Express Version 5, Apache Tomcat).

3.4.7 Tracing, Monitoring y Performance:

3.4.7 Tracing, Monitoring y Performance: alfonsocutro 12 Marzo, 2010 - 13:51- Performance Analyzer muestra los tiempos de ejecución y ayuda a detectar memory leaks.

- Muestra información de los objetos existentes.

- Tiene capacidades de ”Pattern extraction”.

- Es posible monitorizar varios procesos simultaneamente, incluso corriendo en diferentes máquinas.

- Codificación por colores de las clases.

- Presentación de los resultados en modo gráfico y estadístico.

- Soporte de profiling a nivel de objetos.

- Análisis de los logs de WebSphere Application Server e interacción con la bases de datos de problemas.

- Edición de items en la base de datos de problemas.

3.4.8 Debugger:

3.4.8 Debugger: alfonsocutro 12 Marzo, 2010 - 13:53- Muy similar al existente en VisualAge for Java.

- Permite realizar debug tanto a código local como a código residente en el servidor.

Introducción a Intelligent Miner for Data

Introducción a Intelligent Miner for Data alfonsocutro 15 Marzo, 2010 - 11:504.1 Introduccion a la Minería de Datos

4.1 Introduccion a la Minería de Datos alfonsocutro 15 Marzo, 2010 - 11:54La Minería de Datos es el proceso de descubrir nuevas y ú tiles correlaciones, patrones y tendencias dentro de grandes cantidades de datos almacenadas en repositorios, utilizando tecnología para el reconocimiento de patrones así como técnicas matemáticas y estadísticas.

Minería de Datos es el análisis de conjuntos de datos (comunmente grandes) de observaciones para encontrar relaciones inesperadas y presentar los datos en formas que sean tanto entendibles como útiles para el dueno de la información [?].

La Minería de Datos es un campo interdisciplinario (ver fig. 4.1) que conjunta diferentes técnicas desde inteligencia artificial, reconocimiento de patrones, estadística, bases de datos y visualización para realizar la

extracción de información dentro de grandes cantidades de datos [?].

4.1.1 Etapas del Proceso de Minería de Datos

4.1.1 Etapas del Proceso de Minería de Datos alfonsocutro 15 Marzo, 2010 - 12:04Es un proceso que permite descubrir información novedosa y válida, partiendo de grandes almacenes de datos. Donde este proceso implica:

- Seleccionar y transformar datos de entrada.

- Ejecutar una función de minería.

- Interpretar los resultados obtenidos.

Figura 4.1: La Minería de Datos es un campo multidisciplinario

Puede ser un proceso iterativo, siempre en busca de la obtención de la mejor calidad en el resultado.

No se la debe confundir con un gran software. Es un proceso que utiliza diferentes aplicaciones software en las diferentes etapas.

Las etapas del proceso de Minería de Datos abarca las siguientes:

- Selección de los datos de entrada.

- Transformación de los datos de entrada.

- Minería de datos.

- Interpretación de los resultados obtenidos.(ver fig. 4.2).

4.2 Introduccion al IBM Intelligent Miner for Data

4.2 Introduccion al IBM Intelligent Miner for Data alfonsocutro 15 Marzo, 2010 - 12:59Intelligent Miner comunica las funciones de minería con las de preproceso en el servidor, así como las herramientas de administracion con las de visualizacion en el cliente. Se pueden tener componentes de cliente y servidor en la misma máquina.

El componente cliente incluye una interfaz de usuario desde la cual se pueden invocar funciones de un servidor de Intelligent Miner. Los resultados se devuelven al cliente, en el que se pueden visualizar y analizar.

El software de servidor está disponible para los sistemas AIX, OS/390, iSeries, Solaris Operating Environment y Windows, el software de servidor soporta la minería en paralelo con varios procesadores.

El IBM Intelligent Miner for Data (ver fig. 4.3) es un software que comprende un conjunto de funciones: Estadísticas, Preproceso y Minería que se utilizan para analizar grandes volúmenes de datos.

Es conveniente tener conocimientos previos de Bases de Datos y de Estadística.

Ofrece ayuda en todas las etapas del proceso de Minería de Datos.

4.2.1 Componentes IBM Intelligent Miner for Data

4.2.1 Componentes IBM Intelligent Miner for Data alfonsocutro 15 Marzo, 2010 - 13:07Los componentes que integran Intelligent Miner son:

- Interfaz de usuario: Programa que permite definir las funciones de mineria de datos en un entorno gráfico. se pueden definir las preferencias de la interfaz de usuario, que están almacenadas en el cliente (ver fig.4.4).

- API de capa de entorno: Conjunto de funciones API que controlan la ejecución de procesos y resultados de minería. Las secuencias de funciones y operaciones de minería se pueden definir y ejecutar mediante la interfaz de usuario a través de la API de capa de entorno. La API de capa de entorno está disponible en todos los sistemas operativos servidores.

- Visualizador: Herramienta que visualiza el resultado generado por una función estadística o de minería. Intelligent Miner ofrece un amplio conjunto de herramientas de visualizacíon (ver fig. 4.5).

- Acceso a datos: Acceso a datos de archivos planos, tabla y vistas de bases de datos.

- Biblioteca de proceso: Biblioteca que proporciona acceso a funciones de bases de datos.

- Bases de minería: Colección de objetos de minería de datos que se utilizan para un objetivo de minería o un problema de gestión. Las bases de minería se almacenan en el servidor, que permite el acceso desde distintos clientes.

- Kernels de minería: Algoritmos que comienzan a operar cuando se ejecuta una minería de datos o una función estadística.

- Resultados de minería, API de resultado y herramientas para exportación: datos extraídos por la ejecución de minería o la función estadística.

Estos componentes permiten visualizar los resultados en el cliente. Los resultados se pueden exportar para algún proceso posterior o para utilizarlos con herramientas de visualización.

4.3 Instalación e Inicio del Intelligent Miner

4.3 Instalación e Inicio del Intelligent Miner alfonsocutro 15 Marzo, 2010 - 13:084.3.1 Instalación del Servidor para Windows

4.3.1 Instalación del Servidor para Windows alfonsocutro 15 Marzo, 2010 - 13:21- Requisitos de Hardware: El servidor Intelligent Miner para Windows se ejecuta en sistemas con procesadores a 300 MHz o superiores. Para ejecutar IBM DB2 Intelligent Miner for Data en windows, debe instalar uno de los clientes soportados, en la misma máquina o en una máquina remota. El espacio de almacenamiento necesario varía según la cantidad de datos procesados por ejecución. El mínimo es de 128 MB, pero se recomienda utilizar 512 MB de RAM. El espacio de disco necesario para una demostración del producto depende del tipo de partición del disco duro.

- Requisitos de Software: El servidor Windows requiere tener incorporado Microsoft Windows NT, 2000, XP, además un servidor DB2 Universal Database.

El servidor Intelligent Miner de Windows se inicia como un servidor windows nativo denominado IBM Intelligent Miner. El servidor IBM Intelligent Miner se inicia automáticamente al iniciar el sistema.

4.3.2 Instalación del Clientes Windows

4.3.2 Instalación del Clientes Windows alfonsocutro 15 Marzo, 2010 - 13:25- Requisitos de Hardware: El cliente Intelligent Miner para Windows se ejecuta en una estación de trabajo con un procesador a 300 Mhz o superior. El espacio de almacenamiento necesario varía según la cantidades de datos procesados por ejecución. El mínimo es de 128 MB, pero se recomienda utilizar 512 MB de RAM. El espacio de disco necesario para una demostración del producto depende del tipo de partición del disco duro.

- Requisitos de Software: El cliente Windows requiere tener incorporado Microsoft Windows NT, 2000, XP.

4.3.3 Conceptos Básicos del Intelligent Miner

4.3.3 Conceptos Básicos del Intelligent Miner alfonsocutro 15 Marzo, 2010 - 13:29

En general, la minería de datos en Intelligent Miner se consigue por medio de la creación de objetos interrelacionados. Estos objetos se muestran como íconos y representan el conjunto de atributos o valores que definen los datos o funciones. se crean objetos de formulación para llevar a cabo una tarea en concreto.

Intelligent Miner crea otros objetos, como objetos de resultado que contienen los elementos encontrados en una ejecucion de minerìa.

Los objetos de un proyecto de minería de datos concreto se guardan como un grupo denominado base de minería. Se puede crear una base de minería para cada objetivo o proyecto de minería.

Cuando se trabaja con Intelligent Miner, una de las tareas fundamentales consiste en crear objetos de formulación. En el próximo capítulo se indicará paso a paso como dichos objetos.

4.3.4 Funciones de Minería del Intelligent Miner

4.3.4 Funciones de Minería del Intelligent Miner alfonsocutro 15 Marzo, 2010 - 13:30Función Asociaciones

El propósito de esta técnica es encontrar elementos de una transacción que impliquen la presencia de otros elementos en la misma transacción.

Suponiendo que se tiene una base de datos con operaciones de compra, y que cada transacción consiste en un conjunto de elementos que el cliente ha adquirido, la función de minería Asociaciones podría detectar relaciones entre los elementos del conjunto.

Función Clustering Demográfico

El objetivo de descubrir clusters es agrupar registros que tengan características similares.

Intelligent Miner busca en la base de minería las características que se dan con más frecuencia y agrupa los registros relacionados de acuerdo con ello. El resultado de la función de clustering tiene el número de clusters detectados y las caracteristicas que los constituyen. Además, el resultado muestra la forma en que las características están distribuidas en los clusters.

Suponiendo que se tiene una base de un supermercado que incluye la identificación de los clientes e información acerca de la fecha y la hora de las compras. La función de minería clustering podría agrupar en clusters para permitir la identificación de diferentes tipos de compradores.

El Clustering Demográfico proporciona la agrupación de clusters rápida y deforma natural de bases de datos de gran tamaño. Determina automáticamente el número de clusters que se generarán. Las semejanzas entre registros se denominan comparando los valores de los campos. Los clusters se definen para maximizar el criterio de Condorcet. Donde el criterio de Condorcet es la suma de todas las semejanzas de registros de pares dentro del mismo cluster menos la suma de todas las semejanzas de registros de pares en diferentes cluster.

Función Clustering Neuronal

El objetivo de descubrir cluster es agrupar registros que tengan caracteristicas similares.

Intelligent Miner busca en la base de minaría las características que se dan con más frecuencia y agrupa los registros relacionados de acuerdo con ello. El resultado de la función clustering muestra el número de clusters detectados y las características que los constituyen. Además, el resultado muestra la forma en que las carasterísticas que los constituyen. Además, el resultado muestra la forma en que las características están distribuidas en los clusters.

El Clustering Neuronal utiliza una Red neuronal de mapa de características de Kohonen. Los mapas de mapa de características de Kohonen utilizan un proceso denominado organización automática para agrupar los registros de entrada similares. El usuario especifica el numéro de clusters y el número máximo de pasadas sobre los datos. Estos parámetros controlan el tiempo de proceso y el grado de granularidad que se utiliza al asignar los registros de datos a los clusters.

La función principal del Clustering Neuronal es buscar un centro para cada cluster. Este centro se denomina también prototipo de cluster. Para cada registro de los datos de entrada, la función de minería Clustering Neuronal calcula el prototipo de cluster más cercano al registro.

Con cada pasada sobre los datos de entrada, los centros se ajustan de forma que se logra una calidad mejor en el modelo de clustering global. El indicador de proceso muestra la mejor en la calidad en cada pasada durante la ejecución de la función de minería.

Función Patrones Secuenciales

El objetivo de esta técnica es encontrar todas las apariciones de subsecuencias semejantes en una base de datos de secuencias.

Por ejemplo, suponiendo que se tiene una base de datos de un comerciante que desea optimizar sus compras y el sistemas de almacenamiento de; al realizar una ejecución de minería en estas base de datos se obtendrá los nombres de parejas de secuencias con el grado de semejanza y el número de subsecuencias.

Esta técnica tambien se puede utilizar para identificar empresas con patrones de crecimiento similares, determinar productos con patrones de ventas similares o determinar acciones con movimientos de precios similares. Otro uso puede ser la detección de ondas sísmicas que no sean similares o la localización de irregularidades geológicas.

Función Clasificación en Árbol

Se hacen predicciones de las clasificaciones para crear modelos basados en datos conocidos. Estos modelos se pueden utilizar para analizar la razón por la cual se ha hecho una clasificación o para calcular la clasificación de nuevos datos.

Los datos históricos se componen frecuentemente de un conjunto de valores y de una clasificación de estos valores. Si se analizan los datos que ya se han clasificado se descubrirán las características que han contribuido a realizar la clasificación anterior. El modelo de clasificación resultante se podrá utilizar luego para predecir las clases de registros que contienen nuevos valores de atributos.

Se puede utilizar estas técnicas para aprobar o denegar reclamaciones de seguros, detectar fraudes en las trajetas de crédito, identificar defectos en imágenes de componentes manufacturados y diagnosticar condiciones de error. También se puede aplicar para determinar objetivos de márketing, en el diagnóstico médico para determinar la eficacia de los tratamientos médicos, para la reposición de inventarios o en la planificación de la ubicación de una tienda.

El algoritmo de inducción con árbol ofrece una descripción de fácil comprensión sobre la distribución subyacente de los datos. Este algoritmo realiza un ajuste proporcional con respecto al número de ejemplos de preparación y al número atributos que se encuentran en bases de datos extensas. Es conveniente utilizar este técnica para conocer mejor la estructura de la base de datos o para estructurar las bases de datos que no estén clasificadas.

Función Clasificación Neuronal

Se hacen predicciones de las clasificaciones para crear modelos basados en datos conocidos. Estos modelos se pueden utilizar para analizar la razón por la cual se ha hecho una clasificación o para calcular la clasificación de nuevos datos.

La función Clasificación Neuronal emplea una red neuronal de retropropagación para clasificar los datos. La clasificación se basa en el valor de clase y las relaciones de los atibutos descubiertos mediante un proceso de minería realizado en unos datos clasificados anteriormente. El aprendizaje de red significa desarrollar un modelo que represente dichas relaciones, Una red que ha realizado un aprendizaje es una salida de la ejecucíon de minería. El análisis de sensibilidad, otro tipo de salida, se utiliza para comprender la contribución relativa de los campos deatributos en la decisión de clasificación.

Una red nueronal con aprendizaje puede generalizar a partir de su experiencia pasada, y calcular una clasificación razonable incluso tomando como punto de partida combinaciones de atributos que no haya visto nunca.

Función Prediccíon FBR

La finalidad de la predicción de valores es descubrir la dependencia y la variación de un valor de un campo en relación con los valores de otros campos que se encuentren es el mismo registro. Se genera un modelo que puede predecir un valor para ese campo particular en un registro nuevo con el mismo formato, en base a otros valores de campo.